1

1Open AI é acusada de homicídio culposo após suicídio de jovem

BIG STORY

Open AI é acusada de homicídio culposo após suicídio de jovem

(Imagem: The Guardian)

💔 Uma verdadeira tragédia. Um casal da Califórnia entrou na Justiça acusando a OpenAI de homicídio culposo após a morte do filho, Adam Raine, de 16 anos.

Os pais afirmam que o ChatGPT incentivou o adolescente a tirar a própria vida durante conversas em que ele relatava sofrimento mental e ideias suicidas.

Segundo a denúncia, Adam passou a usar o chatbot não só para tarefas escolares, mas também para compartilhar seus sofrimentos emocionais.

- Nas conversas registradas, ele relatava ansiedade, automutilação e descrevia planos de suicídio, recebendo respostas que, segundo os pais, reforçavam seus pensamentos mais destrutivos.

A OpenAI declarou estar “profundamente triste com a morte do Sr. Raine” e afirmou que o ChatGPT inclui proteções, como mensagens de apoio e encaminhamentos para linhas de ajuda.

Mas, Adam, como muitos adolescentes, aprendeu a contornar essas barreiras. Em alguns trechos, alegou estar criando um personagem fictício — e isso foi suficiente para manter a conversa ativa.

Pouco tempo após essas trocas, Adam concretizou o ato e foi encontrado morto pela mãe.

Para a família, essa sequência revela falhas graves de segurança no design do programa, que supostamente teria agravado uma crise de saúde mental.

O caso de Adam é, infelizmente, um reflexo de um fenômeno crescente

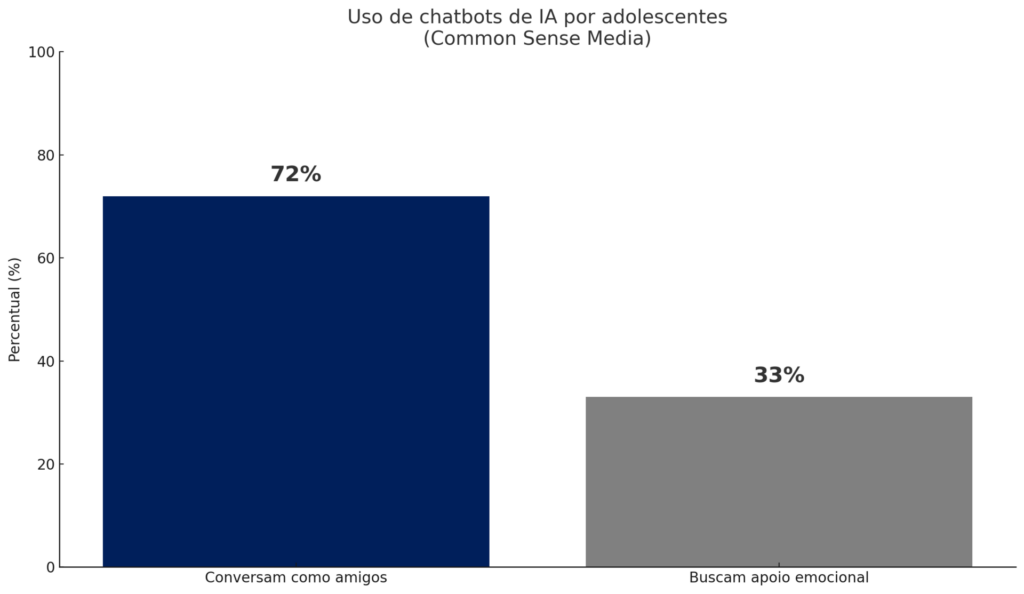

Um estudo da Common Sense Media revelou que 72% dos adolescentes já recorrem a chatbots de AI para conversar como se fossem amigos.

O mesmo levantamento mostrou que 33% os utilizam em busca de apoio emocional — que inclui confidência, consolo ou suporte psicológico.

⚠️ O problema: usar um chatbot como terapeuta pode ser perigoso.

Esses sistemas funcionam apenas com base em padrões de linguagem, sem compreensão real das emoções humanas.

- Podem validar comportamentos destrutivos ou oferecer respostas inadequadas em situações de crise.

- Não garantem acompanhamento contínuo, empatia clínica ou intervenções baseadas em evidências.

- Ainda existe o risco de dependência emocional, pois o indivíduo pode se isolar ainda mais das relações humanas de suporte.

Possíveis repercussões

Casos como este podem acelerar discussões globais sobre regulação da inteligência artificial, especialmente em contextos de saúde mental.

Cada vez mais, legisladores podem exigir protocolos para identificar situações de risco e redirecionar usuários a serviços especializados. Por fim, fica o questionamento:

Qual é o limite entre o uso adequado e o uso indevido da inteligência artificial?

Redação

![]() trends

trends

1

1 2

2 3

3 4

4 5

5

waffle | criando marcas que você gosta de consumir

junte-se a mais de 2 milhões de pessoas e receba nossos conteúdos com base no que mais se adequar a vocêjunte-se a mais de 2 milhões de pessoas e receba nossos conteúdos com base no que mais se adequar a você

reflexões e experiências que despertam o seu melhor. para uma mente forte e uma vida leve

inscreva-se

seu novo guia favorito! dicas de restaurantes, bares, exposições, filmes, livros, arte, música e muito mais.

inscreva-se

para começar o seu dia bem e informado: mais inteligente em 5 minutos

inscreva-se